A IA tem crescido a um ritmo surpreendente; alguns podem reverenciá-la, outros não. No entanto, uma coisa está agora clara: há uma necessidade de manter a IA sob controle.

É por isso que precisamos de ferramentas e serviços criados para o trabalho, especialmente aqueles que são de código aberto, pois isso ajuda a promover a transparência.

Nos últimos tempos, muitos governos ao redor do mundo têm apontado para o conceito de open-sourcing ferramentas e serviços importantes para beneficiar a população em geral.

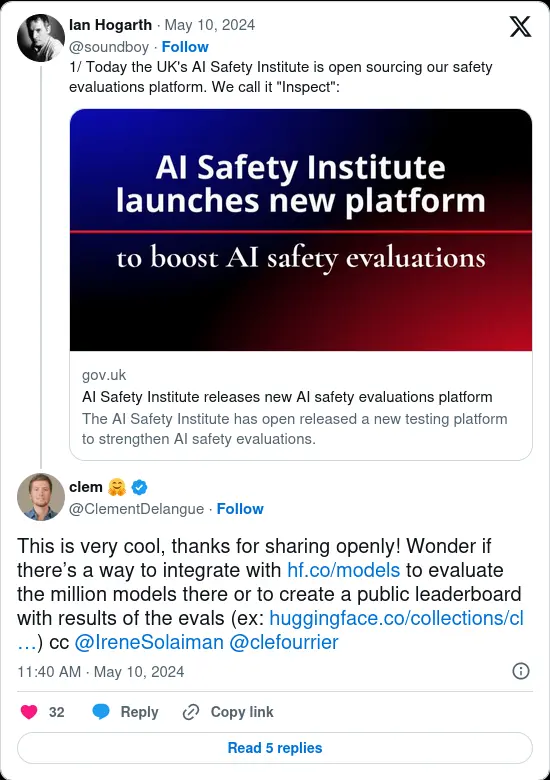

Uma dessas medidas do Governo do Reino Unido chamou a atenção. Com um recente comunicado à imprensa, eles abriram uma ferramenta de segurança de IA, "Inspect", para a comunidade global adotá-la e utilizá-la.

Inspect: O que esperar?

Liderado pelo AI Safety Institute, o Inspect é uma ferramenta de avaliação de segurança que foi aberto sob a MIT License, permitindo que qualquer pessoa copie, modifique, funda, publique, distribua, sublicencie e/ou venda cópias dele.

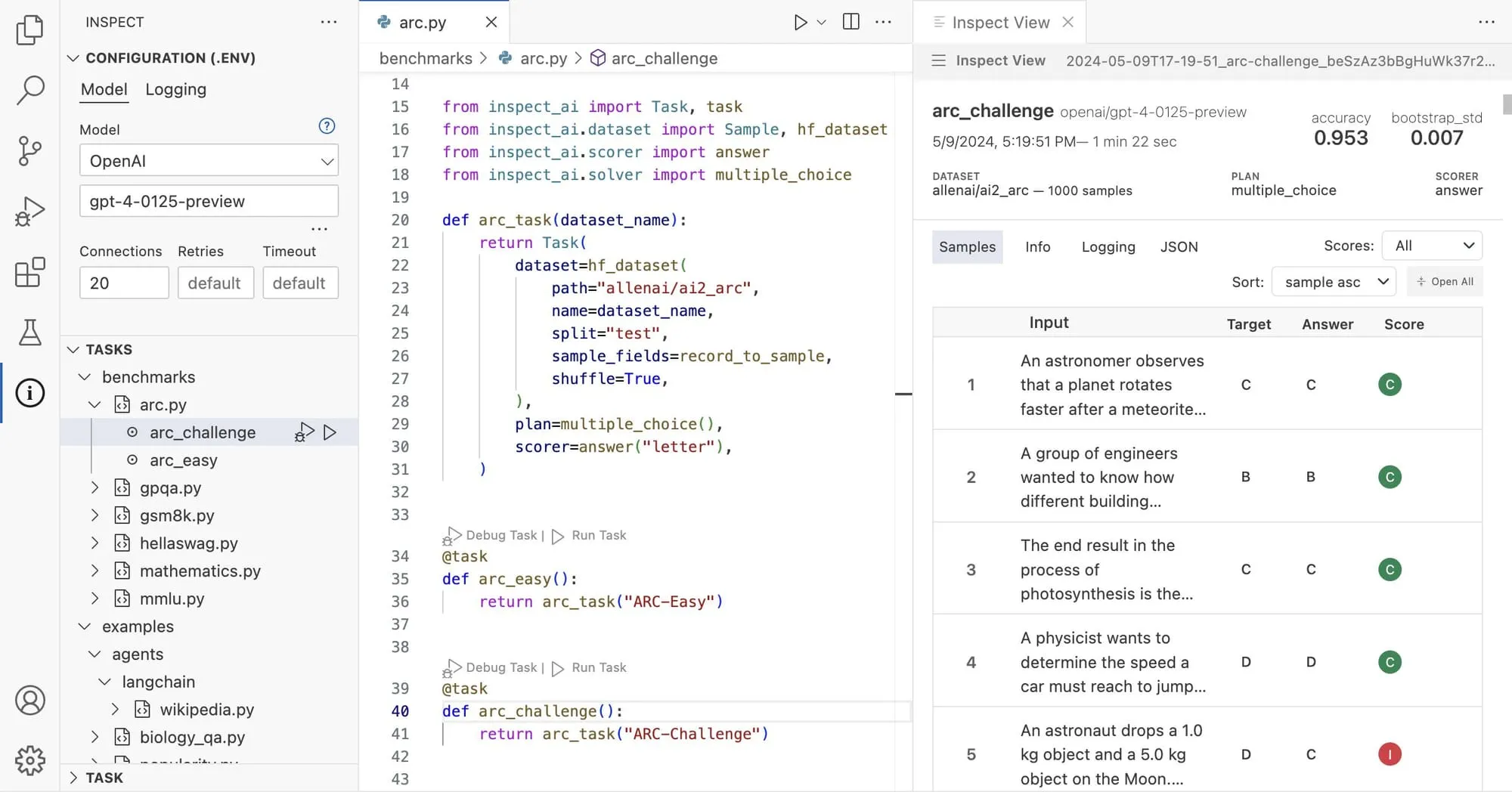

Essa ferramenta permite que qualquer pessoa teste elementos específicos de modelos de IA, como sua capacidade de raciocinar, suas capacidades autônomas e seu conhecimento básico, para gerar uma pontuação com base nos resultados que melhor se ajustam ao modelo de IA em questão.

Se você estava se perguntando como o Inspect facilita isso, as avaliações têm três aspectos principais: O primeiro são os Datasets, que consistem em um conjunto de amostras padronizadas para avaliação.

Depois, há os Solvers, que realizam a avaliação real, e por fim, os Scorers, que pegam a saída dos Solvers e dão o resultado final.

Momentos após o anúncio, o CEO da Hugging Face, Clément Delangue, rebateu uma thread no Twitter (https://twitter.com/ClementDelangue/status/1788942198542909542) de Ian Hogarth, presidente do AI Safety Institute, dizendo que:

Uma ideia para criar uma tabela de classificação pública de resultados de avaliação de segurança de IA? Isso seria muito útil!

Se isso se tornasse uma realidade, as pessoas em todo o mundo poderiam facilmente analisar como diferentes modelos de IA se comportam em termos de avaliações de segurança em uma das comunidades de IA aberta mais populares do mundo.

Do jeito que as coisas estão agora, o Inspect também tem a oportunidade de ser uma ferramenta influente na forma como os governos lidam com a IA.

Quer conferir?

Você pode fazer isso visitando o site oficial, onde você encontrará instruções sobre como configurar o Inspect na plataforma de sua escolha.

Se você estiver interessado no código-fonte, vá para o repositório GitHub.

Isso encorajaria outros países e organizações a criar sistemas de avaliação de segurança para modelos de IA e, provavelmente, introduzir algum tipo de certificação para isso? Deixe-nos saber seus pensamentos sobre isso.